Identifier les non-qualités qui impactent les performances d’un bâtiment

Tel est l’objectif de l’étude lancée par l'AQC intitulée ‘’REX Bâtiments performants & Risques’’

Après avoir présenté la , la troisième trame donc les évolutions rapides qui ont eu lieu dans le secteur de la construction et qui ont bouleversé les pratiques (BBC, RT 2012, etc.) Cette étude s’est focalisé sur les pathologies émergentes, en lien avec la mise en œuvre de produits et procédés innovants, dans le cadre d'une .

Son but est d'identifier les non-qualités qui impactent les performances prévues et empêchent d'atteindre les objectifs modélisés initialement (consommation, confort, qualité sanitaire, etc.) Elle vise aussi à développer l'apprentissage par l'erreur, afin que la filière construction bâtisse, à partir des retours d'expériences, une stratégie délibérément orientée vers la promotion de l'amélioration de la qualité.

L'étude REX Bâtiments performants & Risques s’est portée sur 311 opérations représentatives de l'ensemble des typologies de bâtiments à basse consommation et/ou à haute qualité environnementale (tertiaire, collectif, maison individuelle). Ces bâtiments sont implantés aussi bien en zones rurales qu'urbaines. Cet échantillon comprend pour 38% des opérations de rénovation et couvre globalement les huit zones géographiques concernées par la RT 2012.

Un rapport compile tous les résultats de cette enquête.

Certes l'amélioration de la performance énergétique et de la qualité environnementale des bâtiments ont accéléré les processus de constructions de plus en plus élaborées, mais dont le fonctionnement et les équilibres sont plus sensibles que par le passé.

Dans ce contexte de transition, le recours à des produits et procédés nouveaux se généralise. Les exigences aussi se renforcent et les acteurs de la construction sont confrontés à des obligations de résultats. Ceci implique une montée en compétences, qui se fait par l'expérimentation, étape naturellement génératrice d'erreurs, de désordres...

Les travaux de l'Agence qualité construction sont fondés sur le retour d'expériences. En 2010, l'AQC a décidé de compléter ses outils historiques de connaissance de la pathologie (Sycodés et Alerte, alimentés par les experts construction) par le lancement d'une étude spécifiquement dédiée aux bâtiments performants.

L'apprentissage par l'erreur et le partage des expériences sont au cœur de ce travail. Le but de l'étude REX Bâtiments performants & Risques est de faire connaître les erreurs qui ont pu être commises par les acteurs précurseurs de la construction durable afin qu'elles ne soient pas renouvelées à l'avenir. Cette action n'a pas pour vocation de stigmatiser la construction des bâtiments performants ; elle vise au contraire, à en améliorer la qualité.

Basée sur une enquête de terrain, l'étude REX Bâtiments performants & Risques a pour objet d'identifier les non qualités qui ont un impact sur la performance énergétique ou la qualité environnementale des bâtiments. Les désordres liés à l'utilisation de produits ou de procédés innovants sont également recherchés. La collecte de ces observations se fait in situ, lors de la visite de bâtiments performants et par la rencontre des acteurs ayant participé à leur conception, à leur construction ou à leur utilisation. Dans l'objectif de fournir des leviers d'amélioration de la qualité, les bonnes pratiques mises en œuvre dans ces projets exemplaires sont également capitalisées.

L'échantillon d'opérations visitées contient 62% d'opérations neuves et 38% d'opérations rénovées. La rénovation étant le principal enjeu des années à venir, un effort particulier a été fait pour identifier des projets en rénovation malgré leur nombre moins important.

Les bâtiments visités sont répartis équitablement selon les types d'usages suivants :

• 1 tiers de maisons individuelles ;

• 1 tiers de logements collectifs ;

• 1 tiers de bâtiments tertiaires (bureau, commerce, hôtel, bâtiment de santé, bâtiment culturel, enseignement, etc.).

La plus petite opération visitée présente 97 m2 de SHON ; la plus grande présente une SHON de 80 700 m2 (CERTIVEA).

D'un point de vue énergétique, 54 % des opérations visitées ne sont pas labellisées mais ont un niveau de performance énergétique élevé (A minima BBC d'un point de vue de leur étude thermique). 35 % des opérations visitées sont labellisées BBC Effinergie. Le reste de l'échantillon correspond à des bâtiments labellisés Minergie ou Passivhaus.

D'un point de vue environnemental, 1/3 des opérations visitées sont certifiées (HQE, LEED, BREEAM, etc.).

A titre d'exemple, les bâtiments qui ont recours à l'isolation thermique par l'extérieur (ITE) représentent 53 % du total des opérations visitées (tous types d'usage confondus). Cependant, ce chiffre doit être utilisé avec du recul du fait de la taille réduite de l'échantillon. De plus, la surreprésentation des opérations mettant en œuvre une ITE peut s'expliquer par le fait que certains projets subventionnés avaient l'obligation d'y avoir recours (opérations démonstratrices).

Les isolants bio-sourcés (principalement la fibre de bois et la ouate de cellulose) ont été utilisés dans 20% des opérations.

De la même façon, les statistiques montrent que l'utilisation d'une ventilation double flux est notable dans l'échantillon puisque 38% des bâtiments en sont équipés. Cette fois encore ce chiffre doit être analysé avant d'être exploité. On observe par exemple que des disparités énormes existent suivant le type d'usage (quasiment la totalité des bâtiments tertiaires sont équipés d'une VMC DF, alors que les bâtiments collectifs sont majoritairement équipés de ventilation Hygro B).

Des panneaux photovoltaïques ont été installés dans 13 % des opérations. Le triple vitrage a été utilisé dans 10% des cas.

Enfin, plus d'un quart des projets sont à ossature bois et 13% des opérations disposent d'une toiture végétalisée.

Dans le détail, les résultats de l’enquête sur l’enveloppe montre qu’au niveau de l’étanchéité à l’air, d’une façon générale, il a pu être observé que la réalisation d'une bonne étanchéité à l'air a un impact positif sur la qualité finale du bâtiment. Les finitions sont mieux réalisées et le soin porté aux détails accru. Cependant, dans la quasi-totalité des projets, l'étanchéité à l'air est réalisée en utilisant ponctuellement ou massivement des matériaux non adaptés (mousse polyuréthane, joint à base de silicone, ruban adhésif non adapté...). Les résultats au moment du test de la porte soufflante sont bons, mais quelle sera la durabilité de la performance dans le temps ?

La majorité des problèmes recensés se situe au niveau des interfaces :

• entre les produits ;

• entre les corps d'état.

Outre les problèmes liés à la conception et à l'exécution, les produits et les équipements présentent des défauts d'étanchéité à l'air intrinsèques qu'il faut prendre en compte dans la définition des projets.

Pour remédier aux différents constats, de nombreuses solutions existent et permettent de bien réaliser l'étanchéité à l'air des bâtiments. A titre d'exemples, les travaux apportent un grand nombre de réponses aux problèmes liés à la réalisation de l'étanchéité à l'air :

• les carnets de détails du projet « MININFIL » (CETE de Lyon) qui présentent cependant des incohérences avec les DTU en cours d'identification dans le cadre du programme « Règles de l'Art Grenelle Environnement 2012 » ;

• le film « Etanchéité à l'air des bâtiments » (5 parties). Ce film a été édité par les Régions Alsace, Bourgogne, Franche-Comté et Pays de Loire et les directions de l'ADEME de ces régions.

Par ailleurs, l'amélioration de l'isolation thermique des enveloppes a pour conséquence d'accroître la perception des nuisances sonores à l'intérieur des logements (bruits des équipements...) et entre logements (problèmes de voisinage). L'aspect acoustique doit donc être une préoccupation forte en conception et notamment dans le choix des équipements et de leur positionnement au sein du logement.

Les ponts thermiques ont été répertoriés dans différents types de construction, bois, maçonnerie, notamment en pied de mur, ou au pourtour du nez de dalle. De plus dans le cas d’une conception de balcons solidaires des planchers intermédiaires, cela nécessite le recours à des rupteurs de ponts thermiques. Des infiltrations d'eau, par l'extérieur, au droit des joints des balcons ont été identifiées. Ce constat est aggravé pour les balcons du dernier niveau, non couverts. A l’origine un défaut de conception ou de mise en œuvre difficile. Conséquence un défaut d'étanchéité à l'eau.

S’agissant des ouvertures, là aussi différentes erreurs ont été répertoriées. Le verre central des fenêtres triple vitrage a cassé par choc thermique. L’origine de cet impact est lié aux caractéristiques du produit. L’étude révèle aussi que certains montages des vitrages à faible émissivité ont été exécutés à l'envers.

Ensuite, l’étude mentionne que l'inconfort thermique lié aux surchauffes n'a pas été forcément pris en compte dans les certains cas. Des brise-soleil mal installés, fragiles, rendant une mauvaise qualité d’usage. Ou bien ces protections solaires ont été oubliées lors de la conception, ou il n’a pas été envisagé d’en installer. Résultats un inconfort thermique récurrent en été.

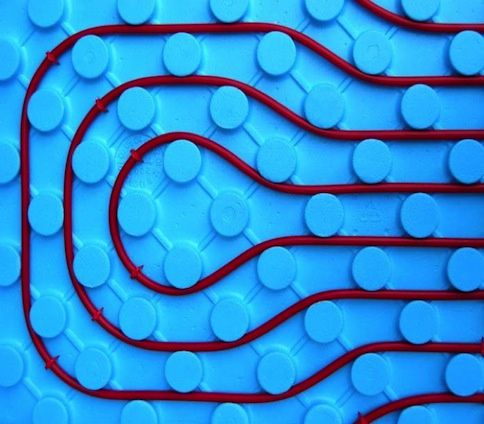

Dans des bâtiments équipés de planchers chauffants, des surchauffes ont été observées en intersaison. Ces surchauffes ponctuelles sont dues au cumul des calories liées aux apports solaire avec celles liées au chauffage. La forte inertie des planchers chauffants est la cause principale de ce problème. En effet, la régulation de ce type d'installation est difficile et l'inertie oblige à une anticipation très à l'avance des apports solaires prévus afin d'éviter les cumuls.

Les besoins de chauffage sont différents suivant les orientations du bâtiment. En intersaison, des surchauffes sont observées dans les logements situés sur les façades les plus ensoleillées alors que sur les façades « nord » il y a encore un besoin de chauffage.

Dans certains cas, le positionnement du caisson de la VMC DF dans les combles non isolés ou à l'extérieur du bâtiment. Le système (moteur, échangeur et gaines), peu ou pas isolé, se retrouve dans une atmosphère très chaude l'été (particulièrement dans les combles non isolés). Ceci limite la participation de la VMC DF au maintien de la fraicheur dans le logement

L’étude a pu ainsi mettre à jour certaines pratiques non préconisées entrainant une perte des performances de l’enveloppe, comme le remplacement de menuiseries par d’autres beaucoup moins performantes. De la même manière qu’un isolant préconisé en conception a été remplacé par un autre isolant moins performant, dont les caractéristiques ne correspondent plus à celles modélisées dans l'étude thermique.

L’étude a aussi soulevé d’autres problématiques. Des problèmes de condensation en phase chantier ont été observés lors de l'enquête. La forte étanchéité à l'air des bâtiments explique en grande partie ce phénomène, mais d'autres facteurs entrent également en jeu comme :

• l'impossibilité d'ouvrir les fenêtres par peur des vols et en cas d'absence prolongée ;

• la saison humide et froide et la situation géographique de l'opération ;

• l'absence des équipements assurant la ventilation et le chauffage ;

• l'impossibilité de brancher la ventilation en place (garantie qui commence à la réception / risque d'encrassement / problème d'alimentation électrique et raccordement EDF) ;

• la mise en œuvre très rapide de l'ITE, ne permettant pas au mur de sécher par l'extérieur

• la mise hors d'eau et hors d'air très rapide (ossature bois) qui n'a pas permis aux murs de refend et aux dalles béton de sécher...

Ce désordre n'est pas nouveau mais il survient plus fréquemment dans les bâtiments à basse consommation. En outre, ses conséquences sont plus graves.

Concernant les équipements, l'enquête révèle que l'absence de locaux techniques adaptés et correctement dimensionnés explique bon nombre des problèmes de maintenance, des problèmes acoustiques et des problèmes de fonctionnement des équipements.

Le constat général est lié au surdimensionnement des équipements de chauffage ayant pour conséquences des courts cycles et une dégradation des rendements (en plus d'un encrassement et d'un vieillissement prématuré). Un impact irrémédiable sur une surconsommation.

Notamment lorsque la température de la pièce met beaucoup de temps à remonter après aération dans des logements chauffés par des radiateurs à basse température (40 °C). L’origine pouvant être multiple : puissance des émetteurs, régulation en fonction de la température extérieure / comportement des usagers.

S’agissant des équipements solaires, les divers constats de l’étude montrent que ces panneaux solaires thermiques ou photovoltaïques sont ombragés tout ou partie de la journée et/ou mal positionnés sur le bâtiment. Les masques solaires n'ont pas été pris en compte lors de l'étude thermique (végétation, autres bâtiments, cheminées, pans de toit...). A l’origine une méconnaissance ou une négligence de la part des concepteurs.

De plus, l'orientation et/ou, dans une moindre mesure, l'inclinaison des panneaux solaires thermiques ou photovoltaïque n'est pas optimale.

De plus, l’enquête montre que les systèmes solaires thermiques sont dépendants de l'électricité et doivent être maintenus sous tension même pendant les périodes d'absence sous peine de stagnation et de surchauffe. Il y a donc consommation d'énergie même pendant les périodes d'inutilisation, entrainant une consommation inutile.

Concernant la VMC double flux, les constats montrent que Ce n'est pas systématiquement stipulé dans les constats suivants, cependant, tous les défauts de maintenance et d'entretien des VMC DF ont un impact sur l'efficacité de ce type d'équipements. En cas de risque de défaut de maintenance, il y a donc forcément un risque de perte de performance associé.

Plusieurs aléas ont révélé que l'échangeur s'est rempli d'eau dans la période qui a suivi la mise en route de la VMC DF, à l’origine une mauvaise mise en œuvre. Ou des VMC DF montées à l'envers. Les gaines d'insufflation et les gaines d'extraction ont été interverties à leur départ du caisson. L'air est soufflé dans les pièces humides et extrait dans les pièces à vivre.

La VMC DF est difficilement accessible car placée dans les combles ou dans le plafond suspendu. Il est nécessaire d'utiliser une échelle pour y accéder (parfois plusieurs mètres de hauteur) Origine : conception.

L’enquête précise aussi les aléas sur le suivi et la maintenance de certains bâtiments. Certains bâtiments sont très performants, car bien conçus et bien réalisés. Il manque cependant un intervenant responsable de leur pilotage. Au-delà des pertes énergétiques liées à la mauvaise optimisation de ces constructions, il arrive que l'absence de pilotage entraîne des sinistres. Les coûts et la complexité des opérations d'entretien et de maintenance croissent avec l'augmentation du nombre de systèmes installés sur les bâtiments. Dans les opérations très « équipées », le discours vendeur sur les économies d'énergie doit être modéré au risque de voir des utilisateurs mécontents. En effet, une partie des économies réalisées sur les consommations d'énergie sert à payer la maintenance plus complexe et plus coûteuse.

Enfin, d’une manière générale, l'étude révèle que dans certains bâtiments, le niveau « basse consommation » a été atteint grâce à la mise en place d'équipements performants et non par une conception bioclimatique élaborée.

De nombreux cas concrets ont permis de constater des défauts. La conception bioclimatique a été négligée du fait des exigences du maître d'ouvrage. La vue (sur la mer, sur un sommet...) a été privilégiée à la recherche de performance et le bâtiment n'est pas orienté de façon optimale. L'étude thermique a été faite en utilisant des surfaces plus grandes que celles déclarées sur le permis de construire. Cette distorsion fausse les calculs et notamment celui de la Consommation en Energie Primaire (CEP) du bâtiment.

L'analyse de l'étude thermique révèle une surévaluation du taux de couverture des besoins en ECS par les panneaux solaire thermique (les BE ont considérés que 80% des besoins en ECS seraient couverts par l'énergie solaire). Or, dans certains cas, les panneaux solaires sont orientés Est ou

Ouest avec des pentes très inférieures à celles requises pour la latitude géographique ou ils ont été installés.

Le plan de relevé du site présentait une erreur de plus de 90° degré par rapport au Nord géographique. L'ensemble des études thermiques a donc été établi suivant une fausse orientation. Cette erreur n'est apparue qu'au stade de l'APD. Seule une partie des plans ont pu être repris sans modification du sens des faîtages

Les séjours sont situés derrière les garages placés au sud. Ces derniers interdisent l'accès à la lumière naturelle et ne permettent pas de bénéficier des apports solaires l'hiver. Les garages n'apparaissent pas dans l'étude RT2005. Les conclusions de cette dernière sont donc optimistes.

Le découpage des parcelles n'a pas permis aux concepteurs d'exploiter correctement les apports solaires et d'intégrer au mieux le bâtiment dans son environnement (vents dominants, effet de masques...).

Les paramètres des cahiers des charges (alignement des façades, alignement des faîtages, adossement ou accolement à d'autres bâtiments, création de places de parking...) sur les parcelles de petites tailles (<400m2) ont été trop contraignants pour permettre une conception bioclimatique de qualité.

Enfin, le passage dans le sas thermique, situé à l'entrée du bâtiment, nécessite une courte attente, du fait que les portes de devant ne s'ouvrent que quand celles de derrières se sont refermées. Pour éviter d'attendre, les employés utilisent la porte de sécurité, située à côté du sas, et la maintiennent ouverte à longueur de journée. Ceci provoque de grosses déperditions en hiver et de forts apports de chaleur en été.

Malgré le grand nombre de désordres déjà identifiés, certaines techniques constructives, certains produits et certains procédés innovants n'ont pas encore fait l'objet de retours d'expériences. Dans ses conclusions, l’enquête rajoute que les bâtiments visités étant très récents, il n'est pas possible dès aujourd'hui d'anticiper tous les potentiels futurs désordres.

Avec l'application de la Réglementation Thermique 2012, ce sont tous les acteurs de la construction qui vont être concernés par la recherche de performances. Il y a donc un enjeu fort à poursuivre et partager les retours d'expériences qui sont une réponse pour garantir les performances et la qualité souhaitées dans les bâtiments d'avenir.

HerreroBoldt Customer Story

HerreroBoldt Customer Story