Pensée du Jour

Adaptées nos villes aux ainés, c’est les rendre accessibles…

Adaptées nos villes aux ainés, c’est les rendre accessibles…

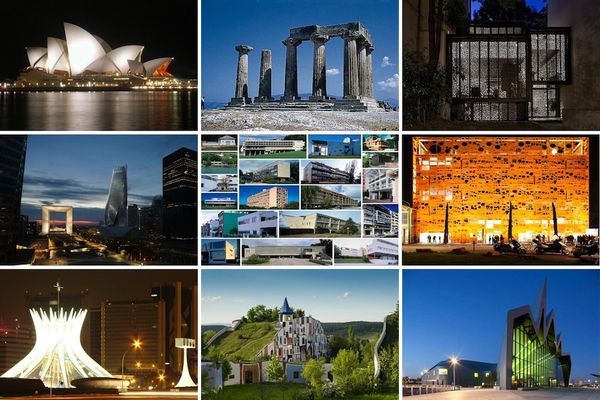

Le Blog souhaite couvrir une large actualité sur l’accessibilité, entre l’application de la loi handicap 2005 qui entend couvrir tous les aspects de la vie des personnes à mobilité réduite demandait une réflexion et un travail de coordination pour la mise en œuvre, même si contraignante, de procédés permettant à nos sociétés valides de s’adapter aux personnes handicapées et non le contraire. C’est pourquoi le blog tente d’élargir la compréhension d’un sujet "ô" combien sociétal. Car l’accessibilité regroupe de multiples thématiques, une particulière relève d’une compréhension sur deux tendances que sont le vieillissement démographique et l’urbanisation. en effet, ce début du XXIème siècle sera marqué par cette disposition. Alors nos villes sont-elles adaptées au vieillissement de la population ?

L’essor urbain s’accompagne d’une augmentation progressive du nombre des citadins de plus de 60 ans. Les personnes âgées constituent une ressource pour leur famille, leur communauté et l’économie lorsqu’elles vivent dans un cadre porteur et favorable. Pour l’OMS, «vieillir en restant actif» est un processus qui s’inscrit dans une perspective globale de la vie et qui est influencé par plusieurs facteurs, isolés ou associés, favorisant la bonne santé, la participation et la sécurité pendant la vieillesse. C’est donc à travers ce cadre que l’OMS s’est inspiré pour proposer un Guide mondial des villes-amies des aînés qui a pour objectif d’inciter les villes à mieux s’adapter aux besoins des aînés de façon à exploiter le potentiel que représentent les personnes âgées pour l’humanité.

Une ville-amie des aînés qui encourage le vieillissement actif en optimisant la santé, la participation et la sécurité des citoyens âgés, pour améliorer leur qualité de vie.

Concrètement, une ville-amie des aînés adapte ses structures et ses services afin que les personnes âgées aux capacités et aux besoins divers puissent y accéder et y avoir leur place.

Pour comprendre ce qui caractérise une ville accueillante pour les aînés, il est indispensable de remonter à la source, à savoir les citadins âgés eux-mêmes. Travaillant avec des groupes répartis dans 33 villes de toutes ses régions, l’OMS a invité les personnes âgées des groupes de discussion à décrire les avantages qu’elles retirent et les obstacles auxquels elles se heurtent dans huit domaines de la vie urbaine. Dans la plupart des villes, les rapports des aînés ont été complétés par les données issues des groupes de discussion constitués d’aidants et de prestataires de soins des secteurs public, associatif et privé. Les résultats obtenus ont permis d’établir un ensemble de feuilles de route concernant les villes-amies des aînés.

L’OMS a fondé ce guide sur l’idée selon laquelle une ville-amie des aînés encourage le vieillissement actif en optimisant les possibilités de bonne santé, de participation et de sécurité afin d’améliorer la qualité de vie des personnes qui vieillissent. Les avantages et les obstacles signalés par quelque 1485 aînés et 750 aidants et prestataires de services consultés dans le cadre de ce projet mondial confirment cette idée et illustrent par de nombreux exemples le maillage complexe des caractéristiques urbaines et des déterminants du vieillissement actif. Le paysage urbain, les bâtiments, le système de transport et l’habitat favorisent les déplacements en toute confiance, les comportements sains, la participation sociale et l’autodétermination ou, au contraire, contribuent à l’isolement dû à la peur, à l’inactivité et à l’exclusion sociale. L’existence d’un large éventail d’opportunités de participation sociale ouvertes aux personnes de tous âges ou à une classe d’âge donnée est propice à l’établissement de solides relations sociales et à l’autonomisation. Une culture qui reconnaît, respecte et inclut les aînés renforce l’autonomisation et le sentiment de sa propre valeur. La diffusion d’informations utiles présentées sous une forme appropriée contribue aussi à l’autonomisation, et à des comportements sains. Des services de santé accessibles et bien coordonnés influent à l’évidence sur l’état de santé des personnes âgées et leur comportement en matière de santé. Si les opportunités d’emplois rémunérés en milieu urbain sont liées aux déterminants

économiques du vieillissement actif, les politiques qui réduisent les inégalités économiques entravant l’accès à toutes les structures, tous les services et toutes les opportunités d’une ville sont plus importantes encore.

Des plans qui favorisent la diversité sont apparus comme l’une des principales caractéristiques d’une ville-amie des aînés souvent reprises dans de nombreux sujets de discussion. La perspective «vieillir en restant actif» de l’OMS décrite dans la Partie 2 considère la période de la vie dans sa globalité; des plans y sont décrits prenant en compte la diversité, favorisant une capacité optimale chez les personnes hautement opérationnelles, et permettent de fonctionner aux personnes âgées qui, sans ces plans, deviendraient dépendantes. Les participants au projet trouveraient normal, dans une ville-amie des aînés, que l’environnement naturel et bâti soit préparé à accueillir des usagers aux capacités diverses et non conçu pour l’individu mythique « moyen » (donc jeune). Une ville-amie des aînés privilégie les aspects porteurs et non les éléments potentiellement incapacitants; elle est accueillante pour les personnes de tous âges, pas seulement pour les aînés. Il doit y avoir suffisamment de bancs et de toilettes publics; les bordures de trottoirs basses en biseau et les rampes d’accès aux bâtiments devraient se trouver couramment, et l’alternance des feux aux passages pour piétons devrait garantir la sécurité de tous. Les bâtiments et les logements devraient être conçus de façon à éliminer les obstacles. Les matériels d’information et les technologies de la communication devraient être adaptés en fonction du niveau de perception, et des besoins intellectuels et culturels. En un mot, il est important que les espaces et les structures soient accessibles.

La reconnaissance et le respect de la diversité devraient caractériser les relations sociales et avec les services autant que les structures physiques et les matériaux. Les participants à ce projet OMS disent clairement que le respect et la considération pour la personne doivent être des valeurs essentielles dans la rue, à la maison et sur la route, dans les services publics et commerciaux, au travail et dans les établissements de soins. Dans une ville-amie des aînés, les usagers des espaces publics devraient se conduire avec respect et partager les équipements collectifs. L’usage prioritaire des sièges réservés dans les transports publics et des zones de stationnement et d’arrêt pour des besoins particuliers devrait être respecté. Les services devraient employer du personnel accueillant qui consacre du temps à chaque usager. Les commerçants devraient servir les personnes âgées aussi bien et aussi rapidement que les autres clients. Les employeurs et les agences devraient assouplir les conditions d’emploi et dispenser une formation aux employés et aux bénévoles âgés. Les communautés devraient reconnaître les contributions présentes, mais aussi passées, des aînés. L’éducation encourageant la sensibilisation, les écoliers devraient être instruits sur le vieillissement et sur les aînés, et les médias devraient les représenter de façon réaliste, non stéréotypée.

L’approche de la vie dans son intégralité associe tous les âges à la promotion du vieillissement actif. La valeur qu’est la solidarité entre générations en fait également partie. Pour les participants au projet, il est aussi important qu’une ville-amie des aînés encourage la solidarité entre les générations et les communautés. Une ville-amie des aînés doit faciliter les relations sociales — dans le cadre des services locaux et des activités qui rassemblent des personnes de tous âges. Les occasions entre voisins de faire connaissance devraient être encouragées; les résidents d’un même voisinage devraient veiller à leur sécurité respective, s’entraider et s’informer mutuellement. Grâce à un réseau de parents, d’amis, de voisins et de prestataires de services en qui ils ont confiance, les membres âgés de la communauté devraient se sentir intégrés et en sécurité. Des contacts personnalisés devraient en outre être établis avec des aînés exposés à l’isolement social, et les obstacles économiques, linguistiques ou culturels auxquels se heurtent de nombreuses personnes âgées devraient être réduits au minimum.

Caractéristiques urbaines intégrées se renforçant mutuellement

Les liens solides entre les différents aspects de la vie urbaine établis par les personnes consultées dans le cade du projet OMS montrent clairement qu’une ville-amie des aînés ne peut résulter que d’une approche intégrée centrée sur le mode de vie des aînés. La coordination des initiatives des différents secteurs de la politique et des services urbains contribuera, selon cette approche, à les renforcer mutuellement. D’après les rapports des aînés et des autres participants au projet, il apparaît comme particulièrement important de suivre une démarche commune qui respecte les relations décrites ci-après.

L’habitat doit être considéré en relation avec les espaces extérieurs et le reste de l’environnement bâti de façon à ce que les logements des aînés soient situés dans des lieux protégés contre les risques naturels et à proximité des services, des autres groupes d’âge et des activités citoyennes qui leur permettent de rester intégrés dans la communauté, mobiles et en bonne santé.

Les services de transport et les infrastructures doivent toujours être reliés aux opportunités de participation sociale, citoyenne et économique, et donner accès aux services de santé essentiels.

L’inclusion sociale des aînés doit cibler des arènes sociales et des rôles qui confèrent du pouvoir et un statut dans la société, comme la prise de décisions dans la vie citoyenne, des emplois rémunérés et la programmation des médias.

Le savoir étant un facteur essentiel d’autonomisation, l’information sur tous les aspects de la vie urbaine doit être accessible à tous en permanence.

Combien de villes en France sont officiellement ville-amie des aînés : elles sont officiellement 19 à être reconnues par l’OMS : Angers, Bar-le-Duc, Besançon, Bey, Carquefou, Dijon, Limonest, Lyon, Le-Havre, Metz, Quatzenheim, Quimper, Rennes, Royan, Saint-Denis de la Réunion, Schœlcher, Strasbourg, Toulouse, Villeneuve-sur-Lot.

Aircity : une simulation 3D de la pollution à Paris

Aircity : une simulation 3D de la pollution à Paris

Airparif et ses partenaires ont développé, dans le cadre du projet Aircity, un prototype qui permet de calculer la pollution à Paris, avec une résolution de trois mètres.

Le dispositif permet de cartographier, sur 120 zones de Paris, les niveaux de dioxyde d’azote et de particules. Il donne une représentation précise de la dispersion de la pollution en fonction du vent et des bâtiments environnants. Dans une ville, la pollution peut se trouver confinée entre les bâtiments dans les rues étroites, car la vitesse du vent y est plus faible. Au contraire, elle est moins présente sur les larges avenues où le brassage de l’air est plus important.

L’objectif du projet est de développer un système de simulation pour représenter et prévoir la pollution atmosphérique en tout point de la ville.

Son système s’appuie sur l’utilisation d’un logiciel, nommé PMSS, déjà utilisé par le CEA dans le cadre de la défense civile. Il a fallu deux ans de pour adapter ce logiciel au domaine de la pollution atmosphérique et pour permettre une représentation cartographique en 3D. On compte au total 450 processeurs pour tout Paris.

Concrètement la réflexion s’est portée sur comment représenter précisément la dispersion de la pollution, rue par rue, en fonction du vent et des bâtiments environnants ? La pollution peut par exemple se trouver confinée entre les bâtiments dans les rues étroites, car la vitesse du vent y est plus faible. Au contraire, les larges avenues favorisent un meilleur brassage de l’air. Les travaux de simulation effectués au quotidien par Airparif, notamment pour les bulletins de prévision pour le jour même et pour le lendemain, permettent une bonne représentation de la qualité de l’air à l’échelle des différents secteurs de la région, mais ne sont pas adaptés pour une représentation locale aussi détaillée.

Une réponse a été apportée par Aircity, projet coordonné par Aria Technologies, l’objectif étant de cartographier les niveaux de dioxyde d’azote et de particules en tout point de Paris, avec une résolution de l’ordre de quelques mètres. Le projet s’appuie sur l’utilisation d’un logiciel, nommé PMSS, déjà utilisé par le CEA dans le cadre de la défense civile. Ce modèle permet de prendre en compte la dispersion physique de l’air en fonction des champs de vent et des obstacles. Deux ans de travaux ont été nécessaires pour adapter le logiciel au domaine de la pollution atmosphérique et pour permettre une représentation cartographique en 3D. Dans une première phase, les calculs ont été menés sur une zone centrale d’environ 4 km2, « l’hyper centre » de Paris, puis ils ont été étendus à toute la capitale comme démonstrateur (plus de 160 km2 pris en compte). Ces zones centrales ont été privilégiées car c’est au cœur de l’agglomération parisienne que la pollution et le réseau de mesure d’Airparif sont les plus denses. Un critère de choix majeur pour une meilleure comparaison entre calculs et mesures.

Airparif a d’abord apporté son expertise pour affiner les données d’entrée du modèle. En effet, la représentation du trafic nécessitait d’être précisée pour suivre très exactement les axes routiers parisiens tels qu’ils sont tracés dans la cartographie élaborée par l’IGN. Il a fallu également assurer que les conditions aux limites, c'est-à-dire l’import de pollution dans le domaine, étaient correctement renseignées grâce au modèle Chimere utilisé à l’échelle de la région. Enfin, Airparif a validé la cohérence du résultat final par rapport aux données de ses stations de mesure réparties dans la capitale.

Cohérence des résultats le long des axes et difficultés pour les places

La validation a été effectuée sur l’hyper centre de la capitale, les résultats des calculs horaires pour les oxydes d’azote étant comparés pendant plus d’un mois à quatre stations d’Airparif situées le long du trafic, au niveau du boulevard Haussmann, des Champs-Élysées, de la place de l’Opéra et de la rue Bonaparte. Cette confrontation statistique a montré que les concentrations étaient bien reproduites le long des axes routiers. Au niveau de la place de l’Opéra, les émissions de pollution du trafic nécessiteraient d’être affinées, étant donnée la complexité de la circulation dans un tel environnement. Par ailleurs, les résultats pour les particules ont été testés sur une journée : ils pourraient être améliorés en prenant en compte la remise en suspension et les réactions chimiques associées à ce polluant. C’est une constante dans la plupart des modèles compte tenu de la diversité des sources de particules.

Ces résultats prometteurs mériteraient d’être validés sur de plus longues périodes. Mais ils offrent déjà de nombreuses perspectives. Très haute résolution, temps de calcul raisonnables, bonne reconstitution physique du vent et de la dispersion, représentation graphique en trois dimensions...

Les performances atteintes permettent d’envisager une utilisation pour des études locales détaillées, rue par rue par exemple, ou même à l’échelle d’une commune entière afin de mieux illustrer le volet « air » d’un PLU (plan local d’urbanisme) ou d’un SCOT (Schéma de cohérence territoriale). On peut aussi envisager l’utilisation de cet outil de modélisation dans les projets d’urbanisme ou de rénovation sur les quartiers fortement exposés à la pollution atmosphérique afin de privilégier des options d’aménagement permettant de réduire cette exposition.

En chiffres :

I Résolution : 3 m

I 2 zones : l’hyper centre (2,3 km par 2,3 km) et Paris tout entier (12 km par 10,5 km)

I 4 stations de mesure Airparif sur l’hyper centre, 20 stations sur l’ensemble de Paris

I Émissions du trafic routier réparties sur 38 000 portions d’axe pour tout Paris

I Découpage de la ville en 120 zones de calcul

I Temps de calcul pour une journée : environ 10h sur l’hyper centre, 14h sur tout Paris

I Moyens de calcul : 24 processeurs pour l’hyper centre, 500 processeurs pour tout Paris soit l’équivalent de 500 ordinateurs personnels

AIRCITY Project - 3D view of air quality in Paris - V2

The AIRCITY Project aims to develop a routine high-resolution air quality now-casting and forecasting tool for the City of Paris. Based on the PMSS code, the simulation system covers a 12x10km area

Une ville à 30 km/h, c’est mobile

Une ville à 30 km/h, c’est mobile

Une ville à 30 km/h au lieu de 50, c’est le crédo de plusieurs associations qui souhaitent voir instaurer la règle de 30 km/h dans nos villes, estimant que la la logique routière n’a aucune raison d’être en ville.

Le club ville 30 estime que la rue n’est pas seulement un espace de circulation : c’est aussi et surtout un espace de vie. Et pour cela il faut lui redonner vie.

Défendant cette conviction, le collectif Ville 30 réclame la généralisation du 30km/h comme vitesse de référence.

Le 50km /h devient alors l’exception et non plus la règle. La mise en place d’une telle mesure permet tout à la fois d’assurer une meilleure sécurité des usagers les plus vulnérables, en l’occurrence les piétons, en particulier les enfants, les personnes à mobilité réduite et les cyclistes, de réduire le bruit et la pollution de l’air dus au trafic urbain, d’inciter les citadins à privilégier la marche et le vélo pour les déplacements de proximité, plus généralement, de pacifier la ville et la rendre plus conviviale.

Ces bénéfices sont parfaitement admis et reconnus. On dispose désormais d’un recul de plus de vingt ans pour en juger, puisque c’est en 1992, à Graz, en Autriche, que pour la première fois l’ensemble d’un centre-ville est passé en zone 30. Depuis, de nombreuses autres villes européennes et françaises se sont inspirées de cette expérience réussie et ont instauré la règle du 30km/h en ville.

6 perspectives pour une ville à 30 km/h :

La ville à 30 permet une circulation apaisée, attentive, civilisée. Dans les secteurs exploités en « zone 30 », l’attention des automobilistes, des conducteurs de motos et de scooters ne se concentre pas uniquement sur les autres véhicules mais sur tout l’espace public. Elle peut s’ouvrir sur la richesse de la vie urbaine, sur tout ce qui s’y joue. Le rétablissement de la priorité à droite aux intersections induit également de leur part des comportements plus respectueux, plus civils et courtois. Tout ceci contribue à apaiser l’ambiance.

///// Une circulation améliorée

Le fait qu’une partie des conducteurs de véhicules motorisés en transit, souvent pressés, soient peu à peu dissuadés d’utiliser les rues en zone 30 permet à ceux qui ont vraiment une raison d’y circuler - résidents, services publics et de sécurité, livreurs, artisans - de pouvoir le faire dans des conditions de circulation améliorées, exemptes de phénomènes de congestion.

///// Le principe de prudence

La circulation dans les zones 30 favorise le respect du plus faible par le plus fort désormais édicté par la loi. Elle instaure en effet un «climat» qui dissuade généralement les automobilistes d’avoir au volant des comportements dangereux pour autrui. Le risque d’accident en est réduit d’autant.

///// Une incitation à se déplacer autrement, à se déplacer « mieux »

Dans une ville 30, la qualité de la vie urbaine s’améliorant, on voit de plus en plus d’automobilistes avoir envie de se libérer de l’auto - en tout cas ceux qui n’ont pas de trop grandes distances à parcourir ! Ils se reportent sur les transports en commun et/ou les modes actifs, avec tous les effets positifs qui y sont associés : santé, sécurité, économie, préservation du cadre de vie, convivialité.

La ville à 30 pour le bien-être, pour la santé et contre la pollution. La sédentarisation croissante du mode de vie a un impact important sur la santé. Pourtant, beaucoup ignorent encore qu’on lui impute une surmortalité au moins égale à celle du tabagisme. Nos modes de vie sédentaires et motorisés augmentent en effet l’incidence des maladies cardio-vasculaires, du surpoids, du diabète, de la fréquence des chutes et de la perte d’autonomie chez les personnes âgées et même de certains cancers.

Or, se déplacer à pied ou à vélo constitue un excellent moyen de s’assurer chaque jour une activité physique d’intensité modérée d’au moins 30 mn (une marche à 4 km/h, par exemple). Telle est, en l’occurrence, la recommandation de l’OMS comme facteur de protection du bien-être et de la santé, et cela quel que soit l’âge des individus.

///// Privilégier les modes de transport actifs

La marche et l’usage du vélo ont fortement diminué au cours du 20ème siècle, disparaissant presque de l’espace urbain pour laisser place à la circulation automobile devenue toute-puissante. L’adoption du 30 km/h comme vitesse de référence en ville peut constituer un puissant levier pour inverser ce mouvement et redonner toute leur place aux modes actifs, pour qu’ils se développent dans de bonnes conditions de sécurité et de confort.

///// La pollution atmosphérique

En ville, les déplacements motorisés sont les premiers émetteurs de pollution atmosphérique et la deuxième source de particules ultra-fines (après le bâtiment). L’émission de ces particules agit sur les voies respiratoires, un phénomène responsable d’un taux de décès de 2 à 31 par 100 000 habitants par an. La réduction des vitesses en ville peut contribuer à lutter contre ce phénomène : selon l’ADEME, elle a un effet positif sur la qualité de l’air dès lors qu’elle n’entrave pas la fluidité de la circulation (évitant ainsi les phases d’accélération).

C’est cependant sur le report modal vers les modes actifs non polluants que l’on doit compter en priorité pour atteindre des objectifs ambitieux en matière d’amélioration de la qualité de l’air. Un report que la ville à 30 permet...

La ville à 30, c’est bon pour la marche et la vie des quartiers. Malgré l’adoption du principe de prudence, l’accidentalité des piétons en ville ne s’est guère améliorée au cours des dernières années, en particulier concernant les personnes âgées. Et pour cause. Le maintien de la règle du 50 km/h en zone urbaine ne permet pas le plein exercice de cette prudence. À cette vitesse, la distance d’arrêt est en moyenne de 30 mètres, alors qu’elle se situe à moins de 15 mètres à 30 km/h. Ce qui se traduit en statistiques : dans un choc à 50 km/h, un piéton a une probabilité d’être tué à 60 % ; à 30 km/h, ce risque tombe à 15 % !

///// Moins de stress, moins de bruit, plus de nature

Un trafic rapide nécessite une attention soutenue de la part de tous les usagers de la rue et constitue une source de stress généralisé, mais dans la ville à 30, cette tension n’a plus lieu d’être et la congestion diminue. La qualité de vie est d’autant plus améliorée que les nuisances sonores dimi- nuent elles aussi de façon sensible,

Autre atout : le gain d’espace. Plus les voitures roulent vite, plus elles ont besoin d’espace. A contrario, dans une ville où les voitures roulent à 30 km/h, la largeur de la chaussée peut être réduite. Cela permet alors d’élargir les trottoirs, d’y installer du mobilier urbain, des bancs, d’y planter des végé- taux, de faire entrer un peu de nature dans la ville et toute mesure incitative à la marche.

///// Un atout pour les commerces de proximité

On sait aujourd’hui que les piétons sont les meilleurs clients pour les com- merces de proximité. Ils achètent moins à chaque fois, mais plus souvent - en moyenne trois fois par semaine. Les cyclistes, eux, achètent deux fois par semaine, contre moins d’une fois pour les automobilistes. Et même si le panier des marcheurs et des cyclistes est moins important, ce sont eux qui dépensent le plus (cf. FUB - Fédération française des usagers de la bi- cyclette). De plus, la fluidité de la circulation est améliorée au bénéfice des livraisons, des déplacements des professionnels et des artisans.

On assiste par ailleurs à un retour de l’attractivité des centres villes et des quartiers commerçants du fait de l’amorce d’un changement de com- portement des consommateurs. Les statistiques disponibles font en effet apparaître une certaine désaffection pour les centres commerciaux périphériques. La réduction des vitesses en ville ne peut que renforcer ce processus et favoriser le retour vers les commerces de proximité.

La ville à 30, c’est bon pour le vélo. À 30 km/h, les vitesses de pointe des cyclistes, des motards et des automobilistes ne sont pas très différentes, limitant les dépassements dangereux. Mais ce n’est pas le seul intérêt pour la sécurité des cyclistes : à 30 km/h, le champ de vision de l’automobiliste et des autres usagers motorisés est également beaucoup plus ouvert. En fait, plus la vitesse est faible, plus le champ de vision est large.

///// Une incitation à la pratique du vélo

La peur de l’accident est un des principaux freins à la pratique du vélo, à commencer par celle des parents pour leurs enfants. Aussi dès que les vitesses baissent, réduisant le nombre et la gravité des accidents, le nombre de cyclistes en ville augmente-t-il très sensiblement.

///// Des aménagements spécifiques

Réduire la place de la voiture permet d’augmenter celle des autres usagers, notamment celle des cyclistes qui peuvent alors bénéficier d’aménagements spécifiques -bandes ou pistes, stationnements sécurisés. Dans une ville 30, les doubles sens cyclables peuvent être généralisés, ce qui permet des trajets plus directs et une réduction des temps de parcours.

///// Une diminution des nuisances

La limitation des vitesses s’accompagnant d’une baisse des pollutions atmosphériques et sonores constitue une incitation à délaisser plus souvent la voiture au profit du vélo... ce qui renforcera la qualité urbaine. Ainsi se crée un cercle vertueux.

///// La ville 30 contribue à réduire les coûts sociaux

Se déplacer à vélo en ville, c’est pratiquer un exercice physique au quotidien. C’est bon pour la santé de chaque cycliste, pris individuellement, mais ça l’est aussi pour la collectivité dans la mesure où cela permet de réduire les dépenses d’assurance maladie. Car ce gain -contrairement à ce qui se dit parfois- n’est pas remis en cause par l’accidentalité des cyclistes (cf. étude ORS IDF - Observatoire régional de santé Île-de-France).

La ville à 30, c’est une ville où l’enfant à sa place. Jusqu’à 10-12 ans, un enfant est pratiquement incapable de se débrouiller seul dans la circulation : il n’a ni le sens du danger, ni les réflexes, ni les capacités sensorielles, ni les facultés de raisonnement d’un adulte.

///// L’enfant n’est pas un adulte en miniature

Un enfant n’a pas la même perception de la rue qu’un adulte du fait de sa taille, du développement de ses sens mais aussi de ses préoccupations et besoins. Pour lui, la rue peut apparaître comme un terrain de jeu... Un enfant n’a pas non plus les mêmes capacités d’adaptation qu’un adulte, ce qui le met en danger lorsqu’un événement inattendu survient comme le surgissement d’une voiture ou un véhicule qui recule. En principe plus en sécurité s’il est accompagné et dans un environnement familier, il a cependant tendance à baisser sa vigilance et à être moins attentif aux dangers de la rue...

///// La perception de l’enfant

Son champ de vision est réduit : alors qu’un adulte voit à 180°, un enfant d’un mètre ne dispose que d’un angle de vision d’environ 70°. Il voit essentiellement droit devant lui. Et de nombreux obstacles obstruent son champ de vision car sa petite taille ne lui permet pas de voir au-dessus des voitures et le rend même souvent invisible au regard des automobilistes. De plus, un enfant confond souvent « voir » et « être vu ».

S’il jouit d’une bonne ouïe, l’enfant a également du mal à déterminer la provenance d’un son. Il ne peut réagir qu’à un seul bruit à la fois et sélectionne toujours celui qui lui paraît le plus important (par exemple, l’appel d’un copain plutôt que le bruit d’une voiture).

Il est donc primordial de prévenir les dangers de la rue en informant aussi bien les enfants que les conducteurs à être extrêmement attentifs à l’environnement dans leurs déplacements. L’adoption du 30 km/h en ville constitue en tout cas une mesure prioritaire pour la sécurité des enfants.

La ville à 30, pour des transports collectifs plus attractifs et plus efficaces. Les transports collectifs ne sont pas confrontés comme les modes actifs au risque automobile. Dans ces conditions quelle est l’incidence de la ville à 30 sur le fonctionnement et l’attractivité des transports collectifs ?.

///// C’est plus de régularité, une meilleure vitesse commerciale et plus de confort

Sur la voirie exploitée effectivement sous le régime « 30 » et qui représentera au moins les 2/3 du linéaire des rues de la ville, la réduction significative du volume de trafic motorisé est absolument nécessaire et doit conduire à la suppression des épisodes de congestion. C’est là le principal profit pour les transports collectifs, tant en gain de vitesses commerciale qu’en régularité et confort.

Sur les quelques axes maintenus à 50 km/h, vitesse commerciale, régularité et confort seront assurés grâce aux modes d’exploitation adaptés et classiques tels que : couloirs réservés, priorité aux feux.

///// C’est une meilleure insertion dans l’espace public

Dans la ville 30 l’espace public affecté à la circulation est grandement réduit. Cela offre la possibilité, notamment, de disposer de plus d’espace pour l’attente et l’information des clients des TC.

///// Les aménagements 30 compatibles avec les TC

Pour inciter ou contraindre les automobilistes à respecter la limitation de vitesse, les concepteurs disposent d’un grand nombre de possibilités d’aménagements. Ces dispositifs doivent être conçus et réalisés afin de ne pas constituer une gêne au bon fonctionnement du service de TC.

Nota : La vitesse commerciale d’un moyen de transport en commun est sa vitesse moyenne sur un trajet donné, elle tient compte de la vitesse de pointe (entre deux stations), du temps passé aux arrêts et, éventuellement, des embouteillages.

La Maison d’Accueil Spécialisée à destination des personnes handicapées à Embrun sort de terre…

La Maison d’Accueil Spécialisée à destination des personnes handicapées à Embrun sort de terre…

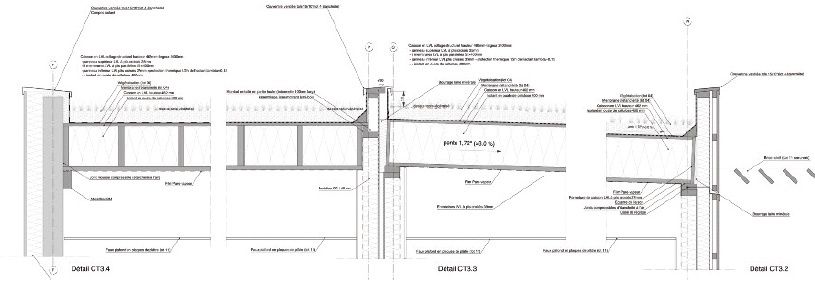

Depuis janvier 2013, une construction est en train de sortir de terre à Embrun : celle d’une Maison d’Accueil Spécialisée (MAS) pour les personnes handicapées vieillissantes. C’est l’association territoriale des Pupilles de l’Enseignement Public (PEP) Alpes du Sud (regroupant les Hautes Alpes et les Alpes de Haute-Provence) qui est à l’origine de cette initiative.

Situé sur un terrain allongé et vallonné, le bâtiment imaginé par Solea Voutier & Associés Architectes s’intègre parfaitement au paysage existant, notamment grâce à ses toitures terrasse végétalisées.

Localisée dans une zone géographique où les chutes de neige sont fréquentes, la MAS d’Embrun devait être équipée d’une toiture performante thermiquement mais également mécaniquement, pour supporter de fortes charges (neige et végétalisation). Le choix du Bureau d’études Structure bois Gaujard Technologie s’est très vite orienté vers les caissons structurels Kerto-Ripa® de Metsä Wood qui combinent l’ensemble de ces avantages.

Crédits photographiques : © Solea Voutier & Associés Architectes

La construction d’une Maison d’Accueil Spécialisée pour les personnes handicapées vieillissantes était attendue depuis 10 ans car aucune structure médico-sociale de ce type n’existait pour les Hautes-Alpes et les Alpes de Haute Provence. 25 personnes pourront ainsi bientôt être prises en charge dans cet établissement situé à Embrun.

Le terrain alloué par la commune pour cette construction se présente en deux terrasses successives. Afin que le bâtiment s’adapte parfaitement à la topographie, la Scop d’architectes Solea Voutier & Associés a fait le choix de l’implanter sur la terrasse basse. Dotée de toitures végétalisées dans le prolongement des parkings, la MAS s’intègre ainsi parfaitement au site en terrasse.

Le projet est constitué de trois niveaux possédant tous un accès de plein pied avec le terrain :

- le niveau haut nommé Rez-de-Chaussée, de plein pied avec le parking paysagé, abrite les espaces d’accueil de l’établissement ;

- le niveau intermédiaire nommé Rez-de-Jardin haut, est occupé par les Unités de Vie organisées autour de patios, les espaces collectifs de vie et les services ;

- le niveau bas nommé Rez-de-Jardin bas, comprend les espaces d’activités et de soins, les locaux techniques.

Une attention particulière a été portée aux éléments des deux toitures terrasse (2/3 du projet), au niveau esthétique mais surtout en termes de performances thermiques et mécaniques. Pour le bureau d’études Gaujard Technologie, spécialisé en structure bois et enveloppe en matériaux biosourcés, le caisson Kerto-Ripa® s’est imposé comme la solution constructive la plus adaptée au projet. Le BET avait déjà eu l’occasion d’expérimenter le caisson Kerto-Ripa® puisqu’il l’avait prescrit pour le collège de Plouagat (22) en 2011.

Les caissons Kerto-Ripa® sont constitués d’éléments en Kerto®, bois d’ingénierie lamifié le plus performant structurellement. L’efficacité et la fiabilité du caisson Kerto-Ripa® viennent du principe de collage structurel entre les nervures en Kerto-S, à plis standards, et le(s) platelage(s) en Kerto-Q, à plis croisés. Le caisson Kerto-Ripa® est environ 6 fois plus raide et 2 fois moins haut qu’un caisson traditionnel en bois assemblé mécaniquement. Fruit de la R&D de Metsä Wood, cette technologie s’impose aujourd’hui comme une solution qualitative et certifiée (ETA, Avis Technique) aux multiples atouts : grandes portées, faibles retombées, raideur, rapidité de pose, légèreté, sécurité incendie, contribution aux bonnes pratiques d’isolation thermique et acoustique.

Les caissons structurels Kerto-Ripa® utilisés sur le chantier de la MAS d’Embrun sont fermés en forme de H et mesurent 2,40 m de large. En face supérieure, le panneau structurel sert de support pour la végétalisation. Une membrane synthétique monocouche assure l’étanchéité.

Du fait de sa situation géographique dans les Hautes-Alpes, la construction de la MAS d’Embrun devait faire face à plusieurs contraintes climatiques. Le caisson Kerto-Ripa® a apporté à la Maîtrise d’Œuvre une réponse complète.

Grâce à l’intégration de l’isolant directement dans le caisson, ce système constructif renforce l’isolation du bâtiment, tout en conservant un large volume d’exploitation intérieur grâce à sa structure très mince. Afin de garantir un confort thermique optimal, 400 mm d’ouate de cellulose ont été insufflés dans les caissons Kerto-Ripa® directement sur le chantier. Le caisson a ainsi permis d’atteindre des performances thermiques de R = 9.2 m2.K/W ponts thermiques compris pour la toiture.

Les performances mécaniques du caisson Kerto-Ripa® sont également à souligner sur ce chantier. Le bâtiment nécessitait en effet d’atteindre des portées de 9 mètres en toiture et de supporter des charges permanentes importantes en raison de la végétalisation et de la neige (270 kg/m2 en moyenne, en tenant compte des accumulations), tout en assurant le contreventement de l'ouvrage.

Pour mener à bien ce projet, l’entreprise de pose en charge du lot bois, Alpes Méditerranée Charpente (AMC), a accompli un travail d’étude d’exécution important et minutieux pour valider tous les détails (calculs des caissons, raccords avec les autres éléments de structure). Les plans de préfabrication ont été réalisés à l’aide du logiciel cadwork.

Préfabriqués par Metsä Wood, les caissons ont été livrés sur le chantier avec leur sangle de levage, prêts à être montés à l’aide d’une simple grue. Au total, 800 m2 de Kerto-Ripa® ont été posés par AMC en 2 phases de 2 jours, entre l’été et l’automne 2013.

L’utilisation des caissons a notamment permis à l’entreprise AMC de réduire le temps de pose initialement prévu.

Coût prévisionnel de l’opération :

5.5 millions d’euros TTC financés par les PEP 05, la commune d’Embrun, l’Agence Régionale de Santé, le CNSA, le conseil régional, le conseil général, la Mutuelle générale de l’Education Nationale (MGEN), le CCAH et un emprunt de l’association auprès de la Caisse des Dépôts et Consignations.

Livraison prévue : Été 2014 Surface SHON : 2 190 m2

Maître d’Ouvrage : PEP des Hautes Alpes

Immeuble Les Hirondelles – 3 rue des Marronniers - 05000 Gap Christian BRUN Tél : 04 92 53 39 97 / Email : siege@lespep05.org www.lespep05.lespep.org

Assistant Maître d’Ouvrage : AGEMO

Immeuble Le Rafale - Zone d'Activités de l'Aéroport 145 impasse John Locke 34470 PEROLS Tél : 04 67 20 35 03 - Fax : 04 67 20 25 21

Maître d’Œuvre Architecte mandataire : SOLEA VOUTIER & ASSOCIES ARCHITECTES SCOP 3 place de Fontreyne – 05000 Gap Jérôme VOUTIER Tél : 04 92 54 18 94 / Email : archi@voutier.fr www.solea-architectes.com

Bureau d’études Structure Bois : GAUJARD TECHNOLOGIE SCOP « Le Sirius » - 355 rue Pierre Seghers - 84000 Avignon Maggy DUCEAU Tél: 04 90 86 16 96 / Email : contact@bet-gaujard.com www.bet-gaujard.com

Entreprise de charpente : ALPES MEDITERRANÉE CHARPENTE Les Hodouls - 05600 Saint Crépin Rémi FILY

Tél : 04 92 20 22 45 / Email : remi.fily@amc05.fr www.alpes-mediterranee-charpente.fr

Entreprise METSÄ WOOD

Division construction Immeuble le Doublon – Bât. A - 11, avenue Dubonnet – 92407 Courbevoie cedex Xavier COLIN, Responsable Systèmes / Projets Tél: 01 41 32 36 36 / Email : xavier.colin@metsagroup.com www.metsawood.com

Nuit - Exposition au Jardin des Plantes, 12 février au 3 novembre 2014

Nuit - Exposition au Jardin des Plantes, 12 février au 3 novembre 2014

Que se passe-t-il durant la nuit, dans le ciel et dans la nature ?

L’exposition, conçue par le Muséum national d’Histoire naturelle, explore le monde de la nuit sous tous ses aspects, mobilise des savoirs scientifiques pluridisciplinaires : astronomie, biologie, éthologie, physiologie, anthropologie, neurologie et évoque également le monde de l’imaginaire au travers des divinités, des mythes et des monstres...

Elle met en valeur un large éventail des collections zoologiques du Muséum. Plus de 350 spécimens sont présentés : mammifères, oiseaux, serpents, amphibiens, papillons, etc. Ils ont été sélectionnés pour la plus grande partie dans les collections, une cinquantaine ont été réalisés spécialement pour l’exposition dans les ateliers de taxidermie.

La scénographie restitue l’ambiance de la nuit. Tout concourt à immerger le visiteur dans le monde à la fois poétique et mystérieux de la nuit. Le parcours commence sous un ciel étoilé, se prolonge par une balade dans une forêt fictive peuplée d’animaux nocturnes en pleine activité, s’achève sur un espace de quiétude sur le sommeil et l’évocation de quelques monstres inoffensifs.

Les dispositifs interactifs interpellent les visiteurs. Le long du parcours, des dispositifs multimédias, sonores, olfactifs, des quiz... impliquent et questionnent. Des fiches pratiques, accessibles par téléchargement via des QR codes, ou sur le site de l’exposition nuit.mnhn.fr, donnent des clefs pour repérer les constellations, des conseils pour préparer une balade nocturne ou une bonne nuit de sommeil.

Le fil rouge : les pollutions lumineuses.

Le thème de la nuit permet d’aborder la menace que constituent les pollutions lumineuses. En plus de la disparition du ciel étoilé, de nombreuses espèces nocturnes (papillons de nuit, oiseaux, mammifères, etc.) sont perturbées, piégées ou repoussées par la puissance et la permanence des éclairages nocturnes. Ce phénomène, aujourd’hui étudié par les écologues, affecte les cycles biologiques des animaux (et le nôtre) régulés par l’alternance jour/nuit, les comportements migratoires et les relations proies-prédateurs. Ce thème est abordé, tel un fil rouge, dans les différentes parties de l’exposition.

La première partie de l’exposition présente au visiteur les bases d’une astronomie observable à l’œil nu et les éléments de compréhension du ciel nocturne. Dans chacun des 3 modules : “Pourquoi fait-il nuit ?”, “La Lune”, “Les étoiles”, une vitrine consacrée aux mythes présente 4 ou 5 objets symboliques des représentations de la nuit et des astres, à travers le monde et les civilisations.

Qu’est-ce que la nuit ?

La nuit est le moment entre le coucher et le lever du Soleil. Un grand mobile Terre-Soleil, illustrant l’alternance jour/nuit permet de répondre à deux questions essentielles :

Pourquoi le Soleil se couche-t-il chaque soir ?

Le Soleil ne se couche pas et ne se lève pas. C’est la Terre qui tourne sur elle-même et pendant qu’une moitié est éclairé par le Soleil, l’autre se trouve dans l’ombre : c’est la nuit.

La Terre tournant sur elle-même en 24 heures environ, chaque nuit devrait durer 12 heures.

Pourquoi la durée de la nuit change-t-elle au cours de l’année et en fonction de la latitude ? Ces différences sont dues à l’inclinaison de l’axe de rotation de la Terre, mais aussi à sa rotation autour du Soleil. À l’équateur, nuit et jour sont toujours égaux. A u-delà, la durée de la nuit varie selon la saison et selon l’endroit où l’on se situe. Plus on se trouve proche des pôles, plus la durée des nuits varie.

Il n’y a que deux journées dans l’année où le jour égale la nuit : ce sont les équinoxes (equi = égale et noxe = nuit), autour du 21 mars et du 21 septembre. Les solstices d’été et d’hiver marquent respectivement la nuit la plus courte et la nuit la plus longue de l’année.

Pas de nuit sans Lune...

La Lune serait née d’une collision entre la Terre et une autre planète en cours de formation. Son diamètre (3 476 km) équivaut à environ 1/4 de celui de la Terre (12 756 km) et sa surface est un peu inférieure à celle du continent américain.

La Lune nous est familière

C’est l’astre le plus proche de la Terre, le seul sur lequel l’homme a mis le pied. Elle est le second astre le plus lumineux de notre ciel après le Soleil, mais elle ne brille qu’en réfléchissant la lumière de ce dernier. Satellite de la Terre, elle met exactement le même temps pour faire un tour autour de la Terre que pour faire un tour complet sur elle-même. C’est pourquoi elle nous montre toujours la même face. En octobre 1959, le satellite russe Luna 3 a pris la première photo de la face cachée de la Lune et le 24 décembre 1968, les membres de l’équipage d’Apollo 8 furent les premiers hommes à la voir directement. C’est le 21 juillet 1969 que Neil Armstrong est devenu le premier homme à marcher sur la Lune.

Quels sont les effets de la Lune ?

Le plus visible est le phénomène des marées. La Lune a aussi une influence sur le comportement de certains animaux, notamment de petits mammifères nocturnes, qui réduisent leur activité les nuits de pleine lune pour éviter de se faire repérer. Et sur l’homme ? En période de pleine Lune y a-t-il plus d’accouchements ? Nos cheveux repoussent-ils plus vite si on les coupe à la Lune montante ? Aucune corrélation fiable et significative n’a été établie.

Comment reconnaître les étoiles ?

Tout ce qui brille dans le ciel n’est pas forcément une étoile... Les étoiles sont d’énormes boules de gaz qui brûlent pendant des milliards d’années et émettent de la lumière. La plus proche de nous est le Soleil. Les autres étoiles de notre ciel sont bien plus loin.

Les planètes, comme la Terre, ne produisent pas de lumière ; elles nous renvoient, comme la Lune, la lumière du Soleil. Et quand on parle de l’étoile du Berger, c’est en fait de la planète Vénus dont il s’agit ! Les étoiles filantes ne sont pas non plus des étoiles mais de simples poussières qui s’embrasent en entrant dans notre atmosphère à très grande vitesse. Il ne faut pas les confondre avec un avion, l’ISS (station spatiale internationale) ou les antennes d’un satellite qui réfléchissent la lumière du Soleil..Petite Ourse, Grande Ourse, Cassiopée

Ces formes familières dans le ciel sont appelées constellations. Ce sont des figures, imaginées par les hommes depuis l’Antiquité, regroupant les étoiles et permettant de se repérer.

La Voie lactée

Toutes les étoiles que nous voyons à l’œil nu appartiennent à notre galaxie, la Voie lactée. Elle contient entre 200 et 400 milliards d’étoiles et chacune de ces étoiles est potentiellement un soleil autour duquel tournent des planètes... Dans l’hémisphère nord, une autre galaxie est visible à l’œil nu — dans de très bonnes conditions — c’est la galaxie d’Andromède.

En 2025 verra-t-on encore le ciel étoilé ?

Théoriquement, on peut voir des milliers d’étoiles à l’œil nu, depuis la Terre, dans un ciel bien dégagé (3000 dans l’hémisphère nord, 6110 pour les deux hémisphères). La plupart des gens ne voient pourtant qu’une étoile sur 10 à cause des éclairages urbains trop puissants et mal orientés. Aujourd’hui, près de 20% de la surface du globe est atteinte par la pollution lumineuse, notion apparue dans les années 1980. Les halos lumineux progressent d’environ 5% par an en Europe

et masquent aujourd’hui la vision de 90% des étoiles dans les métropoles. En France, seuls, en haute montagne, un petit triangle dans le Quercy et une partie de la Corse ne sont pas envahis par les lumières.

+ Pour limiter les nuisances lumineuses et la consommation d’énergie, l’arrêté du 30 janvier 2013 règlemente les dispositifs d’éclairage des bâtiments non résidentiels. Il est entré en vigueur le 1er juillet 2013.

developpement-durable.gouv.fr

La vie nocturne dans la nature

Comment fonctionne la bioluminescence ?

Cette partie, la plus importante spatialement, immerge les visiteurs dans une forêt fictive, habitée par 250 spécimens d’animaux du monde entier, couvrant toute la diversité des espèces nocturnes. Tout au long de la déambulation, quatre espaces “sensoriels”, dotés de nombreux dispositifs interactifs, sonores, olfactifs et multimédias, dévoilent les différentes stratégies et adaptations à la vie nocturne.

Pourquoi certains animaux vivent-ils la nuit ?

Pour la sécurité

Vivre la nuit est une façon d’éviter de nombreux prédateurs diurnes et d’être moins visible... mais certains prédateurs sont également adaptés à la vie nocturne : chouettes et hiboux, aux oreilles affûtées, repèrent les bruissements des petits rongeurs sur les feuilles, le crotale détecte la chaleur de ses proies par ses organes thermosensibles et le vol silencieux des papillons de nuit n’échappe pas au système d’écholocalisation des chauves-souris...

Pour la fraîcheur de la nuit...

De nombreux animaux, surtout dans les régions chaudes, préfèrent les conditions de la nuit : fraîcheur, absence des rayons directs du soleil et taux d’humidité plus élevé sont nettement plus supportables.

Pour se nourrir

De nombreux papillons nocturnes consomment le nectar des mêmes fleurs que leurs cousins diurnes. La nuit offre ainsi un deuxième service ! Même tactique pour l’hippopotame qui broute les mêmes herbes que l’antilope ou le zèbre, qui eux sont diurnes.

Galerie de portraits d’animaux nocturnes

Des silhouettes d’arbres de 3 à 4 mètres de hauteur constituent le décor spectaculaire d’une forêt où plus de 250 spécimens sont en situation, au sol ou perchés. Les collections du Muséum permettent de mettre en valeur aussi bien des espèces de nos contrées que celles de forêts plus lointaines. Les visiteurs découvriront la diversité de ces animaux nocturnes par groupes : marsupiaux, rapaces, rongeurs, chauves-souris, reptiles, amphibiens... accompagnés de petites questions, jeux, vidéos pour mieux connaître ces espèces.

Les marsupiaux

À quelques exceptions près, tous les marsupiaux sont nocturnes. Du koala au kangourou en passant par l’opossum, les 340 espèces recensées présentent une incroyable diversité de forme et de modes de vie.

Les rapaces

Moins de 3 % des oiseaux sont nocturnes et la moitié d’entre eux sont des rapaces. Les hiboux et les chouettes sont les oiseaux qui ont l’ouïe la mieux développée ; ils sont capables de capturer leur proie sans même se servir de leurs yeux.

Les engoulevents, podarges et ibijaux

Ils font partie des rares familles d’oiseaux à être principalement nocturnes ou crépusculaires. La plupart d’entre eux ont la particularité de nicher sur le sol le jour, s’activant la nuit pour chasser en plein vol les insectes dont ils se nourrissent.

Les deux tiers des oiseaux migrateurs effectuent leurs migrations de nuit Un grand nombre d’entre eux s’orientent grâce au géomagnétisme, certains utilisent même la position des étoiles pour se diriger.

Les rongeurs

Écureuils volants, pacas, porcs-épics, castors, mulots, loirs... Avec plus de 2 200 espèces, ils sont l’ordre le plus nombreux des mammifères (40%), et près de 90% d’entre eux sont nocturnes.

Les chauves-souris

Avec plus de 1 200 espèces, de plusieurs kilos à seulement 2 grammes, c’est l’ordre de mammifères le plus nombreux après celui des rongeurs. Elles représentent 1/4 des espèces de mammifères. Contrairement aux idées reçues, elles ne sont pas toutes nocturnes et ne pratiquent pas toutes l’écholocalisation...

Les insectivores

Hérissons, musaraignes, taupes, tenrecs... les insectivores sont pour la plupart de petits mammifères nocturnes et terricoles. La vue n’est pas leur sens le plus développé, ils comptent davantage sur leur ouïe et leur odorat, et certaines musaraignes sont même capables de faire de l’écholocalisation.

Les amphibiens

Grenouilles, crapauds, rainettes, salamandres et tritons... la plupart des amphibiens sont nocturnes et se cachent pendant la journée.

Les reptiles

Les serpents et les crocodiliens comptent de nombreuses espèces nocturnes, mais chez les lézards, seuls les geckos sont principalement nocturnes. Ces reptiles n’ont généralement pas une bonne vue, mais un bon odorat grâce à leur organe voméronasal. Certains serpents sont même capables de repérer une souris dans le noir total grâce à des fossettes thermosensibles qui détectent la chaleur émise par la proie.

Les arthropodes

Parmi plus d’1 million d’espèces recensées, on compte un bon nombre d’espèces nocturnes, principalement chez les araignées, les scorpions, les phasmes, les blattes, les grillons et sauterelles, mais aussi chez les mille-pattes. À noter : 80 % des papillons sont des papillons de nuit.

Les carnivores

Chats sauvages, civettes, loups et ours, ratons- laveurs, fouines, moufettes... Parmi les 280 espèces connues, de nombreux carnivores sont nocturnes et ont une ouïe et une vision bien supérieures aux nôtres. Ils ont aussi un odorat remarquable et utilisent des signaux chimiques excrétés dans leurs urines, fèces ou par des glandes souvent anales. Les moufettes ou les mustélidés, comme le putois, sont des champions dans ce domaine !

Poissons, ongulés, plantes nocturnes complètent cette découverte de la diversité nocturne.

Une nuit de sommeil :

Lorsque la nuit tombe, alors que certains animaux se réveillent et s’activent, d’autres vont entrer dans un état particulier : le sommeil. C’est un phénomène biologique indispensable à la vie qui n’est pas qu’un simple processus de récupération physique. Cette section de l’exposition explore les différentes façons de dormir des animaux, la notion de cycle du sommeil et la place du rêve, pour finir sur le sommeil chez l’homme.

Le “dortoir” d’animaux

Après la forêt, le paysage se poursuit plus graphique, plus onirique. Les visiteurs découvrent un ensemble d’une vingtaine de spécimens naturalisés en position de sommeil : un ours brun confortablement assoupi, un singe lascivement endormi sur une branche, des flamants roses sur une patte, une couleuvre enroulée, un martinet qui dort en planant, une maman écureuil pelotonnée avec son petit, etc. Respirations sonores et légers ronflements animent ce dortoir imaginaire dont les représentants ont été pour la plupart naturalisés pour les besoins de l’exposition. À travers ce bestiaire, nous comprenons les différentes positions de sommeil, leur mécanisme et leur intérêt.

À chacun sa position, plus ou moins confortable...

Dans la quiétude de la nuit, les animaux doivent trouver les bonnes conditions pour dormir : se sentir en sécurité, être à une température adéquate et dans une position plus ou moins confortable.

Dormir ensemble

Les animaux grégaires ont pour habitude de se regrouper pour dormir. Certains oiseaux (perroquets, aigrettes...), après une journée passée à se nourrir, en solitaire ou en petits groupes, se rassemblent sur un arbre dortoir à la tombée de la nuit.

Dormir en équilibre

La plupart des oiseaux et des grands herbivores dorment debout ou en équilibre, prêt à prendre la fuite au moindre danger. Ces positions supposent certains dispositifs anatomiques : articulation des échassiers, blocage osseux des grands herbivores, tendons verrouillés chez les passereaux. Des animaux qui passent la nuit dans les arbres, comme les babouins, dorment en position instable et le moindre mouvement de la branche par un prédateur potentiel les réveillera.

Dormir en se déplaçant

Parce qu’ils ne peuvent se poser comme les martinets, qu’ils doivent effectuer un long voyage sans possibilité de s’arrêter comme les sternes ou qu’ils sont obligés de remonter régulièrement à la surface pour respirer comme les cétacés, certains animaux ne s’arrêtent pas pendant leur sommeil. La solution : dormir d’un demi-cerveau à la fois ou faire du microsommeil.

Dormir confortablement

Dormir dans un lit n’est pas l’apanage de l’homme. De nombreux animaux cherchent ou se confec- tionnent un endroit douillet et sécurisant pour dormir en paix : véritables hamacs ou lits de feuilles pour les grands singes, terrier de la marmotte, enveloppe de mucus secrétée par le poisson perroquet, etc.

Repos ou sommeil : tous les animaux dorment-ils ?

Tous les animaux connaissent des périodes de repos dans une posture particulière mais seuls les oiseaux et les mammifères connaissent un véritable sommeil, présentant les deux phases caractéristiques : le sommeil lent et le sommeil paradoxal. Le sommeil n’est pas un état uniforme, il est constitué d’une succession de cycles de

90 à 120 min - chez l’homme -, avec des phases se succédant toujours dans le même ordre : quatre phases de sommeil lent (endormissement, sommeil léger, sommeil lent profond, sommeil profond) et une phase de sommeil paradoxal, terminée par une phase de pré-réveil très courte. Le sommeil lent, au cours duquel le cerveau est peu actif, est économe en énergie et vital pour la régénération de l’organisme. Lors du sommeil paradoxal, le cerveau est extrêmement actif. C’est le temps des rêves.

À chacun son sommeil

Les durées de sommeil et les durées des phases (sommeil lent, sommeil paradoxal) varient selon les espèces. Les animaux disposant d’un refuge sûr dorment plus et présentent des cycles plus longs que ceux qui vivent dans des conditions précaires. Les herbivores, qui doivent consommer chaque jour une grande quantité de nourriture car

elle est peu énergétique, ont un sommeil plus fragmenté qu’un carnivore qui, de plus, peut jeûner plusieurs jours entre chaque repas. La girafe dort peu, à peine 4 heures par jour et surtout debout. Quant au chat domestique, prédateur, carnivore, solitaire, avec 20 heures de sommeil, il fait partie des champions des dormeurs.

Le sommeil évolue au cours de la vie, en durée et en qualité

Déjà dans l’œuf ou dans le ventre de sa mère, le poussin ou le fœtus montre des signes de phases de sommeil et d’éveil. Lorsque le petit naît, il passe environ 90% de son temps à dormir. Mais on ne dort pas de la même façon au cours de la vie : chez les oiseaux comme chez les mammifères, la quantité de sommeil paradoxal est environ cinq fois plus élevée chez le petit qu’à l’âge adulte. Et avec l’âge, le sommeil perd peu à peu en qualité et quantité.

Et vous, quel dormeur êtes-vous ?

Après une bonne nuit... tout va mieux, mais encore faut-il avoir eu un sommeil de qualité. Il faut savoir écouter son horloge biologique qui nous avertit de notre besoin de sommeil. La tombée de la nuit est aussi un signal pour l’organisme. Malgré ces signaux, les perturbations sont multiples : retard de l’endormissement provoqué par la lumière des différents écrans, une chambre trop chaude ; insomnie, terreur nocturne, somnambulisme. Savez-vous ce qu’il faut faire ou ne pas faire pour bien dormir ? La nuit porte-t-elle conseil ? Et à quoi rêvez-vous ? Des dispositifs interactifs permettent aux visiteurs de réponse à ces questions et de pouvoir raconter leurs rêves... qui resteront anonymes.

Le capteur de rêves suspendu au-dessus du lit du dormeur, il retient les cauchemars dans sa toile d’araignée. Seuls les bons rêves parviennent à redescendre jusqu’au dormeur.

Loups-Garous, vampires et autres croque-mitaines... d’où viennent ces créatures de la nuit qui peuplent notre imaginaire ?

Au cours d’une nuit de sommeil peuplée de rêves... surgissent les créatures de la nuit, monstres cachés dans le noir, sous le lit, dans le placard. Courtes séquences de films, grimoires et jeux d’ombres témoignent de la force des imaginaires d’où sont nés vampires, croquemitaines et autres loups-garous.

Les monstres de la nuit, effrayants ou imaginaires ?

La nuit et son obscurité, ses mystères, le sentiment d’insécurité qu’elle peut générer, ont créé de sombres personnages et ont terni la réputation des loups, chouettes, hiboux et chauves-souris. La tradition orale, la littérature et le cinéma

ont abondamment mis en scène les frayeurs nocturnes. De tous les monstres de la nuit, les vampires et les loups-garous sont les plus connus. Héros de romans, de cinéma ou de séries télévisées, ils sont devenus presque familiers : de Nosferatu à Twilight, du loup-garou de Londres au lapin- garou de Wallace et Gromit.

Croque-mitaine, loup-garou et vampire

Le croque-mitaine est un monstre qui fait peur au moment de se mettre au lit. On le rencontre dans toutes les cultures sous des formes différentes (humaine, monstrueuse, animale). Il peut agir dehors ou dans la chambre, être à la recherche d’enfants ou se contenter d’attendre qu’ils soient endormis pour les attraper. Pour ne pas avoir affaire à lui, il faut être sage, bien dormir, et se tenir à l’écart des situations dangereuses.

Le statut du loup-garou est plus complexe. C’est un humain qui, par malédiction ou par choix, peut se transformer en loup à la tombée de la nuit ou les soirs de pleine lune.

Il apparaît dans les légendes depuis l’Antiquité. La peur du loup entretenue depuis le Moyen Âge, certaines maladies psychiques ou bien physiques notamment l’hypertrichose – c’est-à-dire un développement de la pilosité – ont forgé cette créature, mi-homme, mi-animal. Selon les cultures, les garous prennent la forme de l’animal le plus redouté. En Occident c’est un loup mais ce peut être un crocodile en Asie, ou un coyote au Mexique...

Quant au vampire, c’est un mort-vivant immortel. Il est pâle, se nourrit de sang et peut prendre des formes diverses pour tromper la vigilance des hommes : se changer en loup ou en chauve- souris, deux animaux dont la dangerosité a été nourrie par les naturalistes, notamment par Buffon. Chaque culture a ses vampires : en Occident, Dracula est le plus connu, héros du roman à succès de Bram Stoker et de nombreux films. Pour se débarrasser d’un vampire, les remèdes sont connus : de l’ail, du gros sel, de l’eau bénite, un crucifix et un pieu pour lui transpercer le cœur.

Jeux d’ombres

Avant de quitter le monde de la nuit, un espace ludique dédramatise les peurs nocturnes : on joue aux ombres chinoises et la nuit devient un tableau noir propice à la création.

Pensée du Jour

Quelles mesures pour le projet de loi sur l'adaptation de la société au vieillissement ?

Quelles mesures pour le projet de loi sur l'adaptation de la société au vieillissement ?

Ce projet de loi dont le coup d’envoi a été donné, en novembre 2013, par le lancement des concertations menées par Michèle Delaunay, ministre déléguée chargée des Personnes âgées et Marisol Touraine, ministre des Affaires sociales et de la Santé avec un panel d’acteurs du médico-social, les départements et collectivités territoriales, les partenaires sociaux, mais aussi avec les acteurs du logement, des transports, de l'urbanisme, de la citoyenneté et de la silver économie vient de franchir une nouvelle phase.

Ainsi, pendant deux mois, pas moins de 80 réunions ont été organisées, rassemblant plus de 500 participants et une trentaine de contributions versées au débat. Ces échanges constructifs qui ont associé très étroitement l'Assemblée des Département de France, ont permis d’enrichir et finaliser le texte du projet de loi qui sera dans les tout prochains jours transmis au Conseil Economique, Social et Environnemental (CESE), pour une présentation en Conseil des ministres le 9 avril et un dépôt au Parlement au printemps. Ainsi le projet de loi pourra-t-il être adopté avant la fin de l’année 2014, conformément à l’engagement qui a été pris devant les Français.

Parce qu'en 2060, un tiers des Français aura plus de 60 ans, ce projet de loi repose sur trois piliers indissociables, les fameux trois A :

- l’anticipation, pour prévenir la perte d’autonomie de façon individuelle et collective

- l’adaptation de notre société tout entière à l’avancée en âge

- l’accompagnement de la perte d’autonomie, avec pour priorité de permettre à ceux qui le souhaitent de rester à domicile dans de bonnes conditions le plus longtemps possible.

Cette loi est une première étape législative. La deuxième étape de la réforme, dont la mise en œuvre est prévue pour la seconde partie du quinquennat, portera sur l’accompagnement et la prise en charge en établissement. Elle intègrera des mesures permettant de réduire le reste à charge des résidents en EHPAD.

Les principales mesures

Jean-Marc Ayrault a choisi Angers classée "Ville Amie des Aînés" par l'Organisation Mondiale de la Santé pour dévoiler les grandes orientations de la loi.

► Améliorer l’accès aux aides techniques et aux actions collectives de prévention

Aménager son domicile et recourir à la téléassistance et à la domotique sont des moyens souvent simples de prévenir chutes et perte d’autonomie. 140 millions seront consacrés à ce volet prévention et à l'aménagement du domicile.

► Développer des politiques de l’habitat et de l’urbanisme prenant mieux en compte l’avancée en âge et lancer un plan national d’adaptation de 80 000 logements d’ici 2017.

► Donner un nouveau souffle aux foyers-logements, rebaptisés Résidences Autonomie, grâce à la **création d’un "forfait autonomie", qui permettra de renforcer leurs actions de prévention, pour un montant de 40 millions d’euros. Et de manière inédite l’Etat participera à la rénovation des foyers-logement, via un Plan exceptionnel d’aide à l’investissement de 40 millions d’euros qui s’ajouteront aux 10 millions d’euros déjà dégagés en 2014.

► Poser un acte II de l’APA à domicile : près d'1,2 million de personnes bénéficient de l'APA dont 60% vivent à leur domicile. Le Gouvernement souhaite :

- une APA plus généreuse : les plafonds d’aide mensuels de l’APA seront revalorisés de 400 euros en GIR 1, de 250 euros en GIR 2, de 150 euros en GIR 3 et de 100 euros en GIR 4. Cette revalorisation touchera donc tous les bénéficiaires de l’APA, quel que soit leur degré de dépendance.

- une APA plus accessible grâce à la diminution du reste à charge qui pèse aujourd'hui sur

les âgés et leurs familles. Aucun bénéficiaire de l’allocation de solidarité aux personnes âgées (ex minimum vieillesse) n’acquittera plus, désormais, de ticket modérateur.

- une APA plus qualifiée, grâce à la professionnalisation des aides à domiciles, l’amélioration de leurs conditions de travail, la lutte contre la précarisation des salariés et à une meilleure prise en compte de leurs frais professionnels. 25 millions d’euros y seront consacrés chaque année.

Au total, 375 millions d'euros supplémentaires seront consacrés à l'APA chaque année.

► Reconnaître le rôle des aidants en créant une aide au "répit"

4,3 millions de personnes aident régulièrement au moins un de leurs proches âgé de 60 ans ou plus à domicile, "parfois au prix de leur propre équilibre ou de leur santé" a souligné le Premier ministre. "La loi consacre ainsi une aide au répit, afin de permettre à l'aidant de s'absenter quelques jours en garantissant que le relais sera pris auprès de l'aidé. D'un montant qui pourra aller jusqu'à 500 euros annuels au-delà du plafond de l'APA, cette aide permettra par exemple de financer sept jours de séjour dans un hébergement temporaire."

RT 2012 et PHPP : Audition à l’Assemblée Nationale afin de corriger le tir pour ne pas freiner l’innovation ?

RT 2012 et PHPP : Audition à l’Assemblée Nationale afin de corriger le tir pour ne pas freiner l’innovation ?

Un logiciel réglementaire moins précis que le PHPP

La Réglementation Thermique 2012 a instauré une nouvelle version du logiciel réglementaire, pour permettre aux maîtres d’œuvre et entreprises de respecter les nouvelles contraintes imposées, notamment une meilleure prise en compte de la conception bioclimatique. Concrètement, le logiciel doit permettre d’envisager et comparer les choix techniques (notamment thermiques) dès la phase de conception.

Problème : les données sur lesquelles s’appuient ses calculs sont conventionnelles, c’est-à-dire purement théoriques et, de l’avis général, peu précises.

Second problème : l’instauration d’un moteur de calcul unique et exclusif a pour conséquence d’exclure ou de compliquer la tâche des autres logiciels de conception. C’est notamment le cas du PHPP, pourtant beaucoup plus précis dans son anticipation des usages énergétiques.

Alors coup d’œil sur le PHPP :

Le PHPP (Passive House Planning Package) est à la "maison passive" ce que les deux roues sont au vélo : il permet non seulement de concevoir l’habitation pour s’assurer qu’elle respectera les très faibles consommations énergétiques recherchées, mais en plus c’est aussi l’outil de validation de la construction et qui sert de base pour l’attribution d’une certification (Passivhaus Institut Darmstadt, Plateforme Maison Passive belge, La Maison Passive en France, etc...)

Le PHPP est constitué d’un logiciel, facile d’emploi puisque programmé sous Microsoft Excel et d’un gros manuel, qui n’est pas gros parce que le logiciel est compliqué, mais parce qu’il permet à l’occasion de la description du logiciel de revenir sur de nombreux aspects pratiques de la "construction passive". Donc le PHPP, c’est bien plus un "outil de conception" qu’un seul programme : c’est un outil d’accompagnement à la conception passive.

Le logiciel qui n’est pas à proprement parler un outil de simulation dynamique, puisqu’il utilise la méthode d’approximation mensuelle, a été validé conceptuellement par la simulation dynamique et dans la pratique par plus de 200 constructions dont les consommations énergétiques ont été passées au peigne fin sur de nombreuses années, ce qui permet de confirmer par l’expérience la justesse des résultats que fournit le système.

Le PHPP est "L"’outil de la maison passive par excellence. Il est plus simple d’utilisation qu’un logiciel de simulation dynamique (et plus rapide dans la "virtualisation" de la conception). Cela dit, même s’il est relativement simple, il faut quand même "entrer" la construction correctement. Sinon, les résultats risquent d’être décevants.

Le logiciel est basé sur les normes européennes, notamment l’EN 10077, l’EN 673, l’EN 410, l’EN 13790, etc...

Corriger le tir pour ne pas freiner l’innovation ?

C’est pourquoi, 2 ans après le lancement du logiciel, l’Office parlementaire d’évaluation des choix scientifiques et technologiques (OPECST) organise une audition publique des acteurs de l’innovation dans le bâtiment intitulée ‘’Economies d’énergie dans le bâtiment : comment le moteur de calcul réglementaire intègre-t-il l’innovation ?’’

L’Office a pour objectif d’identifier les freins qui empêchent les composants et les équipements porteurs d’innovation, donc par définition dotés de caractéristiques inédites, d’être intégrés au calcul RT 2012.

Le témoignage de La Maison Passive

La Maison Passive vous donne donc rendez-vous jeudi 13 février matin pour assister à l’audition publique à l’Assemblée Nationale. Etienne Vekemans, Président de La Maison Passive, apportera son expertise dans le cadre de l’intervention « Les modalités de gestion d’un moteur de calcul » à partir de 9h20.

Il exposera en quoi le PHPP est un logiciel propice à l’innovation, notamment grâce à une intégration facilitée des nouveaux produits par rapport au logiciel THBCE.

Le PHPP est un outil clairement structuré qui peut être utilisé directement par les concepteurs et les architectes.

Le PHPP possède des outils pour :

— calculer des valeurs U des composants de forte isolation thermique.

— calculer des bilans énergétiques.

— concevoir la ventilation de confort.

— calculer la charge de chaleur.

— calculer le confort d’été. et beaucoup d’autres outils pratiques pour une conception maison passive de qualité.

La version actuelle, PHPP2004 possède les feuilles de calcul suivantes :

— Vérification du bâtiment passif : sélection de la méthode de calcul, résumé des résultats.

— Surfaces : feuille centrale d’entrée des données de l’enveloppe. Pour une plus grande clarté, les données sont automatiquement consolidées en groupes de surfaces et leurs pertes thermiques sont résumées. Les valeurs U sont sélectionnées par le biais d’un menu pull-down. Cela simplifie grandement la gestion des données. Les ponts thermiques et la surface de référence sont aussi entrés ici.

— Liste des valeurs U : résultats des calculs de la feuille "Valeurs U" et base de données des éléments de construction.

— Valeurs U : feuille de calcul des valeurs U des éléments de construction. Les calculs de transmission thermiques sont basé sur EN ISO 6946, en y incluant les composants angulaires ainsi que les composants composites du style construction bois.

— Sol : calcul des pertes thermiques par le sol, basé sur les algorithmes de EN 13370 qui ont été revus et complétés. La feuille de calcul inclut des algorithmes qui traitent le cas des ponts thermiques ainsi que les effets de l’eau sous-terraine.

— Fenêtres : détermination de Uw et de la radiation extérieure, en considérant les effets de la géométrie, de l’orientation, des propriétés thermiques du vitrage et du chassis, des coefficients de ponts thermiques ainsi que du climat.

— Fenêtres types : liste des vitrages et des chassis ainsi que de leurs caractéristiques. Contient une base de donnée de composants maison passive.

— Ombrage : détermination de l’ombrage en considérant les balcons, casquettes et constructions voisines.

— Ventilation : dimensionnement du système de ventilation à partir des besoins en air frais, des valeurs d’infiltration et de celles de la récupération de chaleur. Entrée des résultats des tests de pressurisation.

— Besoin de chaleur de chauffage : calcul du besoin annuel de chauffage, selon les procédures de bilan thermiques d’après EN 832 (méthode annuelle). La feuille de travail montre un bilan énergétique clairement structuré.

— Méthode mensuelle : calcul du besoin en chaleur annuel selon la méthode mensuelle EN 832, présentation graphique du bilan mensuel.

— Puissance de chauffage : calcul de la puissance de chauffage nominale du bâtiment utilisant une méthode simple appropriée aux maisons passives. Une technique pour vérifier si la sortie thermique du système central de fourniture de chaleur est suffisant pour les pièces critiques a été rajouté.

— Eté : calcul de la fréquence de surchauffe d’été en tant que valeur de confort d’été.

— Ombrage d’été : détermination des facteurs d’ombrage pour l’été.

— Ventilation estivale : estimation des flux d’air nécessaires à la ventilation estivale "naturelle".

— ECS + distribution : calcul des pertes de chaleur du système de distribution (chaleur, ECS). Calcul des besoins en ECS habituels ainsi que leurs pertes de stockage.

— ECS solaire : calcul de la fraction d’ECS fournie par le système solaire.

— Electricité : calcul de l’électricité domestique ansi que de l’énergie primaire consommée par le bâtiment.

— Electricité auxiliaire : calcul de l’électricité et des besoins en énergie primaire des auxiliaires (pompes de circulation etc...)

— Calcul EP : sélection des générateurs de chaleur, calcul de l’énergie primaire et des rejets de Co2 associés.

— Systèmes compacts : calcul de la performance d’une unité compacte utilisant une pompe à chaleur pour le chauffage et/ou l’ECS aux conditions limites du projet.

— Chaudière : calcul de la performance de la production de chaleur à base d’une chaudière classique (basse température ou à condensation, au gaz, au fioul ou au bois) aux conditions limites du projet.

— Chauffage urbain : calcul des besoins en énergie finale et en énergie primaire dans le cadre de la cogénération.

— Données climatiques : les données climatiques peuvent être selectionnées parmi plus de 200 localisations en Europe et aux USA.

— Apports internes : calculs des apports de chaleur internes.

— Données : tables de coefficient d’énergie primaire, etc..

Pas forcément si idéal le chauffage par le sol !

Pas forcément si idéal le chauffage par le sol !

Si le plancher chauffant constitue une technologie très courante actuellement notamment dans les nouvelles constructions ou dans les rénovations d’envergure pour des questions de confort et d'économie d'énergie, et aussi pour des raisons d’une technique maîtrisée et efficace, Il s’avère, dans certains cas, incommodant ou énergivore à cause, principalement, de sa grande inertie.

Dans les bâtiments peu isolés et occupés de façon assez intensive, une inertie importante ne pose généralement pas de problème. Par contre, elle peut être à l'origine de surchauffes dans des bâtiments peu déperditifs, surtout quand il existe un apport solaire ou des apports internes importants. Par exemple, lors de belles journées de mi-saison, l'inertie du chauffage sol d'un plateau de bureaux largement vitré et ensoleillé fera en sorte que le sol apportera encore des calories bien que la température de consigne intérieure soit atteinte et que le chauffage soit coupé. On se retrouve dès lors dans une situation paradoxale : pour éviter la surchauffe, on ouvre les fenêtres ou, pire, la climatisation est mise en service.

Afin de limiter les risques de surchauffe, l’inertie thermique du plancher chauffant devra être la plus faible possible. Cette règle ne s’applique pas aux murs et plafonds non actifs (dépourvus d’éléments chauffants) car ils contribuent à « lisser » les variations thermiques. Pour limiter la surchauffe, on prévoira surtout des protections solaires efficaces.

L’inertie de ce genre de chauffage s’avère également gênante dans les bâtiments occupés de manière sporadique. En effet, il n’y est pas toujours facile d’anticiper les besoins en chaleur et de les gérer avec ces systèmes peu réactifs. Par exemple, dans une salle des fêtes : les horaires d'occupation sont généralement très irréguliers et parfois imprévisibles, il sera donc difficile d'anticiper de manière suffisamment précise l'heure optimale de la relance. En pratique, ceci risque de se traduire par le maintien d'un chauffage permanent.

De façon analogue, des occupations ponctuelles et régulières ne sont pas non plus optimales pour des systèmes inertiels. Par exemple, pour une bibliothèque communale occupée quelques heures réparties sur plusieurs jours de la semaine, il serait nécessaire, avec un chauffage sol inertiel, d'anticiper le fonctionnement du chauffage et, au final, de chauffer sur une période sensiblement plus importante que la durée d'occupation réelle. Dans ce cas, on ne réalisera certainement pas d'économies d'énergie.

Enfin, lorsque le plancher chauffant est placé au-dessus d'espaces non chauffés (caves ou vides ventilés, par exemple), les déperditions vers ces espaces seront plus importantes du fait de la température du sol. Ces déperditions pourront cependant être limitées par une isolation performante préalable à la pose du chauffage.

Il faut cependant préciser qu'un chauffage par le sol se combine idéalement avec un système de pompe à chaleur ou des chaudières à condensation car ce type d'émission permet de travailler avec des températures d'eau très basses. La pompe à chaleur ne devra pas vaincre une différence de température trop importante et sera donc performante, tandis que les retours "froids" favoriseront la condensation dans les chaudières exploitant cette technologie.

Récemment, de nouveaux systèmes de chauffage sol à faible inertie ont vu le jour. L’inertie de ces systèmes (± ½ heure) se rapproche plus d’un système de chauffage par radiateur et se distancie donc nettement des chauffages sols inertiels (plusieurs heures), ce qui évite la plupart des désagréments précités dans les cas spécifiques envisagés.

S’inscrivant dans un souci constant d'amélioration du confort en toutes saisons, a conduit au développement des systèmes de planchers chauffants/rafraîchissants aussi communément appelés planchers réversibles.

Le plancher chauffant/rafraîchissant assure deux fonctions :

le chauffage en hiver,

le rafraîchissement en été.

Ainsi, avec un fluide chaud, le plancher se comporte en émetteur l'hiver, et avec de l'eau rafraîchie en absorbeur durant l'été.

La technique du plancher rafraîchissant n’est en aucun cas un dispositif de climatisation mais plutôt un système permettant d’apporter un certain confort en abaissant la température ambiante de 3 à 5 K.